Każdego dnia Twoja strona, blog lub sklep internetowy są odwiedzane nie tylko przez użytkowników docelowych, ale też przez roboty należące do popularnych wyszukiwarek. Skanują one Twój serwis i indeksują nowo dodane przez Ciebie produkty, wpisy czy – ogólnie – podstrony, a także dbają o aktualność tych już istniejących w ich indeksie (a przez to możliwych do wyszukania). O ile sam proces jest automatyczny, możesz go stymulować i odpowiednio ukierunkować. Temu właśnie służy plik robots.txt, któremu poświęcony jest nasz dzisiejszy wpis.

Spis treści

Czym jest robots.txt?

Robots.txt to niewielkich rozmiarów plik tekstowy, stworzony wyłącznie z myślą o robotach wyszukiwarek internetowych, które regularnie skanują Twoją stronę i indeksują jej nowe (oraz zmienione) podstrony. Plik ten stanowi pierwszą rzecz, na którą patrzą przy podchodzeniu do tego skanowania, a jednocześnie instrukcję dotyczącą ich pożądanych i niepożądanych działań. Można w nim więc wskazać, by nie indeksowały wybranej przez Ciebie podstrony (na przykład tej z danymi dotyczącymi cen) lub by w pierwszej kolejności spojrzały na mapę Twojej strony. Bez pliku robots.txt roboty wyszukujące będą skanowały i, w razie potrzeby, indeksowały cały Twój serwis. Bez jakichkolwiek wyjątków.

Dlaczego warto posiadać robots.txt?

Choć robots.txt nie wpływa w żaden sposób na samo działanie strony internetowej, ma decydujący wpływ na to, co jest wyświetlane robotom wyszukującym (a w rezultacie – co pojawia się w wynikach wyszukiwania). Instruuje je, gdzie znajdą ważne dla nich informacje (w tym mapę strony), ale też znacząco wpływa na obciążenie serwera. Dzięki niemu roboty nie skanują niepotrzebnie stron, których nie powinny. To też sprawia, że możesz w ten sposób tak ułatwić im prace, jak i pominąć treści, które mogłyby negatywnie odbić się chociażby na pozycji Twojej witryny w wynikach wyszukiwania.

Jeśli Twój serwis działa w oparciu o popularny system zarządzania treścią (WordPress, PrestaShop i inne), plik robots.txt może już u Ciebie istnieć. Istnieje kilka sposobów na sprawdzenie, czy już go posiadasz. Znajduje się on w folderze głównym z plikami Twojej strony. W związku z tym możesz sprawdzić jego obecność za pośrednictwem klienta FTP (z poziomu którego możesz też go edytować) lub po prostu wpisując adres Twojej strony ze wskazaniem na ten plik (nazwastrony.pl/robots.txt). Jego obecność sprawdzisz też w narzędziu Google Webmasters (opcja Tester pliku robots.txt), które przy okazji sprawdzi poprawność zawartych w nim zasad. Więcej na ten temat – poniżej.

Jak stworzyć plik robots.txt?

Istnieją dwa sposoby na to, by wejść w posiadanie pliku robots.txt. Nie ma jednak tego najlepszego. Każdy bowiem prowadzi do powstania pojedynczego pliku z regułami, które następnie odczyta robot wyszukujący (zanim w ogóle zacznie skanować Twoją stronę). Jeden z nich jednak umożliwia łatwiejszą, bo zautomatyzowaną kontrolę nad zawartymi w pliku regułami.

- Ręczne stworzenie pliku. Roboty Google, ani też jakiejkolwiek innej wyszukiwarki internetowej, szukają pliku robots.txt w lokalizacji następującej bezpośrednio po domenie internetowej. Nie ma dla nich przy tym znaczenia, jak ten plik faktycznie powstał. Możesz więc po prostu zapisać reguły w pliku tekstowym, a następnie wrzucić go do folderu głównego swojej witryny internetowej. To rozwiązanie, z którego korzystają przede wszystkim posiadacze stron, które rzadko kiedy się zmieniają lub też nieczęsto chcą blokować robotom dostęp do nowo powstających podstron.

- Dynamiczne generowanie pliku. Niektóre systemy CMS pozwalają na wygenerowanie pliku robots.txt poprzez ich panel administracyjny. Odpowiednio opracowana wtyczka robi to automatycznie, dzięki czemu nie musisz pamiętać o aktualizowaniu pliku. System sam to zrobi, na przykład w momencie, gdy pojawi się podstrona, której nie chcesz indeksować. To rozwiązanie najwygodniejsze dla osób, które często lawirują pomiędzy ustawieniami widoczności podstron w wyszukiwarce.

Najważniejsze reguły w pliku robots.txt

W pliku robots.txt mogą znaleźć się różne reguły, używane w zależności od potrzeb, wskazujące robotom wyszukującym (nie tylko tym od firmy Google, ale i chociażby te pochodzące z wyszukiwarki Bing!) ich pożądane działanie. Poniżej przedstawiamy te najczęściej używane.

User-agent

Plik robots.txt może zawierać definicje kierowane do wszystkich robotów wyszukujących, albo też takie, na które ma zwracać uwagę tylko któryś z nich. Za to właśnie jest odpowiedzialny parametr User-Agent. Jeśli chcesz, aby następujące po nim reguły odnosiły się do wszystkich robotów, musisz skorzystać z kodu:

Jeśli zaś kierujesz te komendy do wybranego robota, w miejsce gwiazdki wpisz jego nazwę (możesz oddzielać je przecinkiem, dla definicji kierowanych do kilku robotów jednocześnie). Reguły pod tym kodem, aż do zdefiniowania kolejnego parametru User-agent lub do końca pliku, będą tyczyły się wybranego robota. Najpopularniejsze oznaczenia dla robotów wyszukujących to:

- Googlebot – robot wyszukiwarki Google,

- Googlebot-Image – robot usługi Google Zdjęcia,

- Googlebot-Video – robot usługi Google Wideo,

- AdsBot-Google – robot usługi Google Ads,

- Googlebot-News – robot usługi Google News,

- Bingbot – robot wyszukiwarki Bing!

Allow / Disallow

Parametrami Allow oraz Disallow możesz kolejno zezwolić lub zabronić robotowi dostępu do wybranych podstron lub całych ścieżek Twojej strony internetowej. Domyślnie, parametr Allow odnosi się do wszystkich podstron Stosowany jest chociażby wtedy, gdy chcesz utworzyć wyjątek od blokady (czyli na przykład blokujesz wszystkie podstrony ze ścieżką rozpoczynającą się od /folder/, ale jedną z nich chcesz udostępnić robotowi). W obu przypadkach kod wygląda następująco:

lub też:

W obu tych przypadkach znacznik "/" odnosi się do całej strony. Pierwszy kod blokuje więc robotom dostęp do całej strony. Zamiast niego, możesz podać ścieżkę (bez domeny) do konkretnej podstrony (na przykład /sekcja/podstrona.html) lub też dowolną regułę (na przykład /*.pdf$ – blokuje wszystkie pliki z rozszerzeniem .pdf). Więcej na temat reguł powiemy w osobnym poradniku. To samo możesz zaaplikować oczywiście do „odblokowywania” plików czy całych ścieżek.

Sitemap

W pliku robots.txt możesz także najłatwiej wskazać robotom wyszukującym adres mapy Twojej strony w formacie xml (najlepiej sitemap.xml). Wystarczy, że zastosujesz poniższą regułę:

W ten sposób robot będzie zaczynał skanowanie właśnie od niej, co znacząco poprawi jakość indeksacji.

Podsumowanie

Plik robots.txt jest jednym z tych niewielkich elementów, które mają olbrzymi wpływ na widoczność Twojej strony internetowej (lub sklepu czy bloga) w wyszukiwarce internetowej. Musisz jednak pamiętać, że jest on zaledwie jedną ze składowych świetnie przygotowanej i dobrze radzącej sobie w Internecie strony. Aby nie zapomnieć zarówno o nim, jak i o wszystkich pozostałych rzeczach oraz ich poprawności, powierz swoją stronę internetową nam – firmie NextGen Group.

Jesteśmy specjalistami w tworzeniu, promowaniu i zarządzaniu stronami, które generują konwersje i którymi nasi klienci z dumą chwalą się przed innymi. Skontaktuj się z nami, a z chęcią przyjrzymy się Twojemu wizerunkowi w sieci i dopracujemy go w taki sposób, byś mógł wycisnąć z niego absolutne maksimum (albo też po prostu go stworzymy). W nowoczesny i oczekiwany przez Twoich odbiorców, ale i wyszukiwarki internetowe sposób.

Linki nofollow i dofollow – czym się różnią, jak je stosować i jak wpływają na SEO?

Jak zwiększyć szybkość ładowania strony internetowej?

Błąd 500 – czym jest i jak go naprawić?

Poznaj WooCommerce! Sklep internetowy w WordPress

Błąd łączenia z bazą danych WordPress. Jak naprawić?

Inne artykuły z tej kategorii

Zobacz inne nasze artykuły które mogą Ci się spodobać

ReCAPTCHA v3 – czym jest i jak wygenerować kod

21.02.2024 6 min Tworzenie i zarządzanie stronami

Wraz z rozwojem technologii cyfrowych ruch generowany przez użytkowników sieci staje się coraz „gęstszy” i coraz więcej obszarów ludzkiego życia może być zarządzane online. Z jednej […]

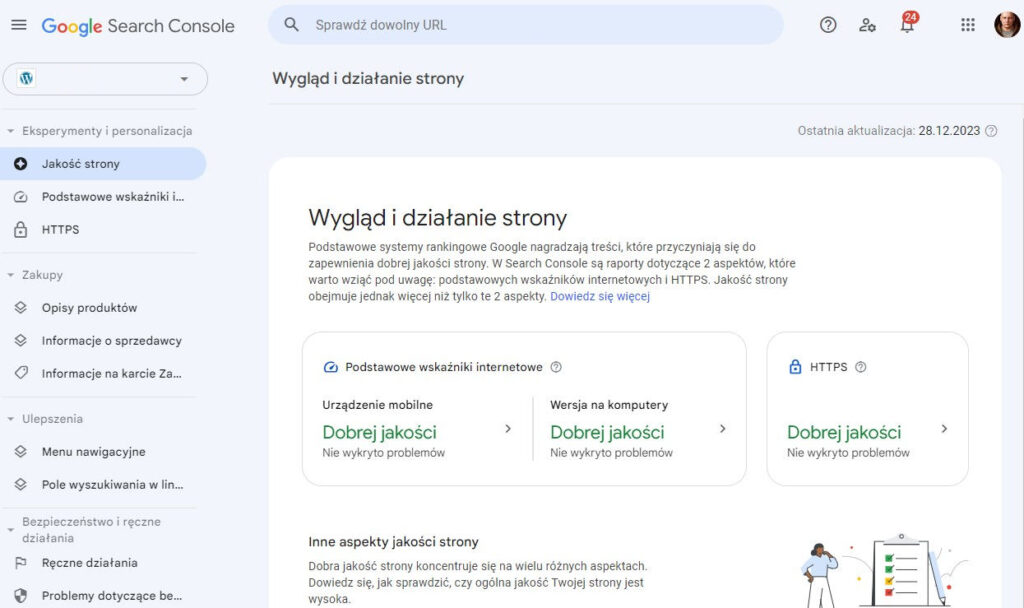

Jak dodać stronę do Google?

24.01.2024 5 min Tworzenie i zarządzanie stronami

Stworzenie strony internetowej czy dodanie na nią nowej treści nie jest równoznaczne z uwidocznieniem ich w rankingach Google. Wyszukiwarka Google dopiero po pewnym czasie otrzymuje informacje […]

Lazy loading – jak pomoże Twojej stronie?

19.12.2023 5 min Tworzenie i zarządzanie stronami

Współcześni użytkownicy Internetu doceniają szybkość ładowania stron internetowych. Chcą w możliwie najkrótszym czasie dotrzeć do poszukiwanych treści, a w przypadku wydłużonego czasu oczekiwania wybierają inną witrynę. […]